主页(http://www.kuwanit.com):HBM2E 和GDDR6: AI内存解决方案

前言 人工智能/机器学习(AI/ML)改变了一切,影响着每个行业并触动着每个人的生

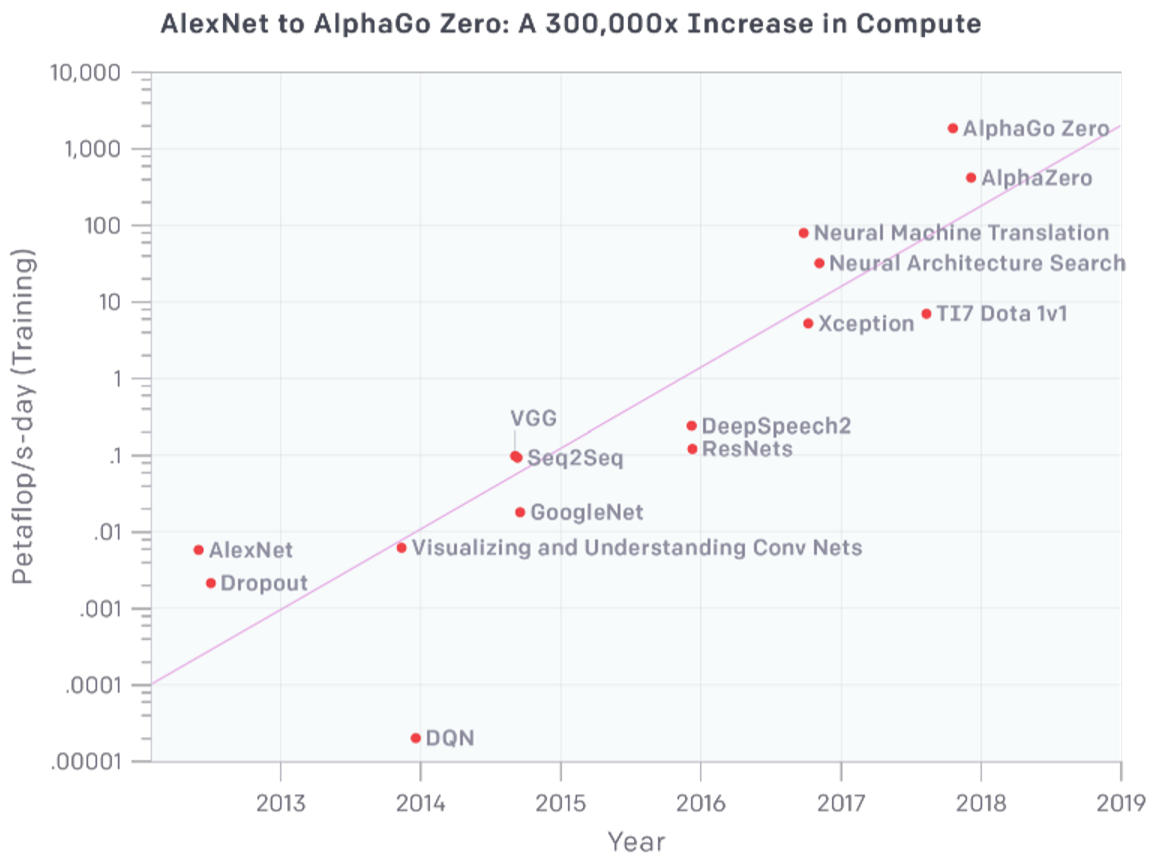

活。人工智能正在推动从5G到物联网等一系列技术市场的惊人发展。从2012年到

2019年,人工智能训练集增长了30万倍,每3.43个月翻一番,这就是最有力的证

明。支持这一发展速度需要的远不止摩尔定律所能实现的改进,摩尔定律在任何情况下都在放缓,这就要求人工智能计算机硬件和软件的各个方面都需要不断的快速改进。

从2012年至今,训练能力增长了30万倍

内存带宽将成为人工智能持续增长的关键焦点领域之一。以先进的驾驶员辅助系统(ADAS)为例。第3级及更高级别系统的复杂数据处理需要超过200 GB/s 的内存带宽。这些高带宽是复杂的AI/ML算法的基本需求,在道路上自驾过程中这些算法需要快速执行大量计算并安全地执行实时决策。在第5级,即完全自主驾驶,车辆能够独立地对交通标志和信号的动态环境作出反应,以及准确地预测汽车、卡车、自行车和行人的移动,将需要巨大的内存带宽。随着新一代AI/ML加 速器和专用芯片的快速发展,新的内存解决方案,如高带宽内存(HBM、HBM2 、HBM2E)和GDDR6 SDRAM(GDDR6)渐被采用来提供所需的带宽。

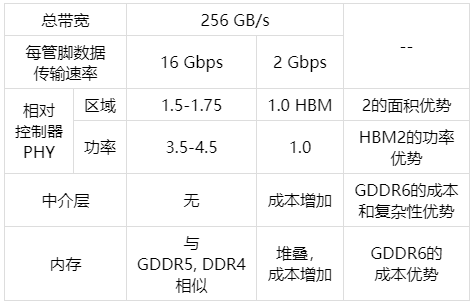

在为AI/ML应用程序所需而在HBM2E(最新一代HBM)和GDDR6之间做选择时,设计者必须考虑许多权衡和关键指标,包括成本、功率、容量和实现复杂性。在本白皮书中,我们将探讨HBM2E和GDDR6的优点和设计注意事项。我们还将强调每个内存在整个AI/ML架构中的适用性。最后,我们将讨论Rambus的HBM2E和GDDR6接口解决方案,它们可以用来实现一个完整的内存子系统。

GDDR6 和HBM2E 提供了不同的优点和设计权衡

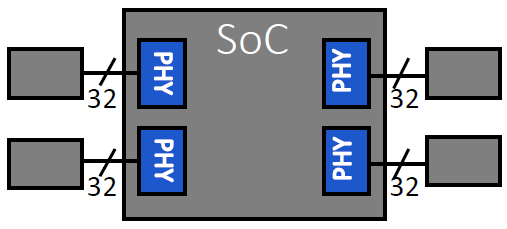

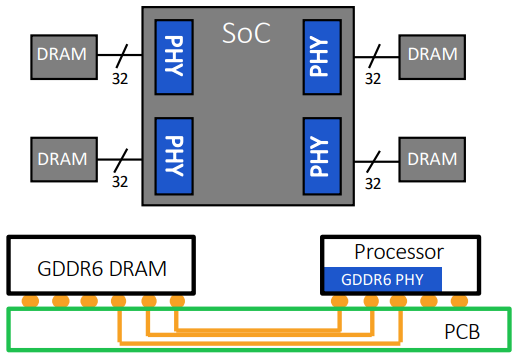

GDDR6 内存系统四个16Gbps x32 GDDR6 DRAMs

第一部分:HBM2E 内存

高带宽内存(HBM)于2013年推出,是一种高性能3D堆栈SDRAM构架。与前一代产品一样,HBM2为每个堆栈包含最多8个内存芯片,同时将管脚传输速率翻倍,达到2 Gbps。HBM2实现每个封装256GB/s的内存带宽(DRAM堆栈),采用HBM2规格,每个封装支持高达8GB的容量。

2018年末,JEDEC宣布推出HBM2E规范,以支持增加的带宽和容量。当传输速率上升到每管脚3.6Gbps时,HBM2E可以实现每堆栈461GB/s的内存带宽。此外,HBM2E支持12个DRAM的堆栈,内存容量高达每堆栈24 GB。

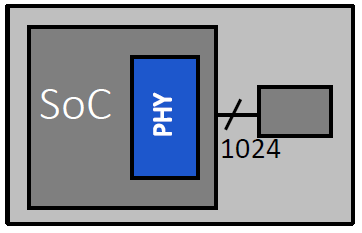

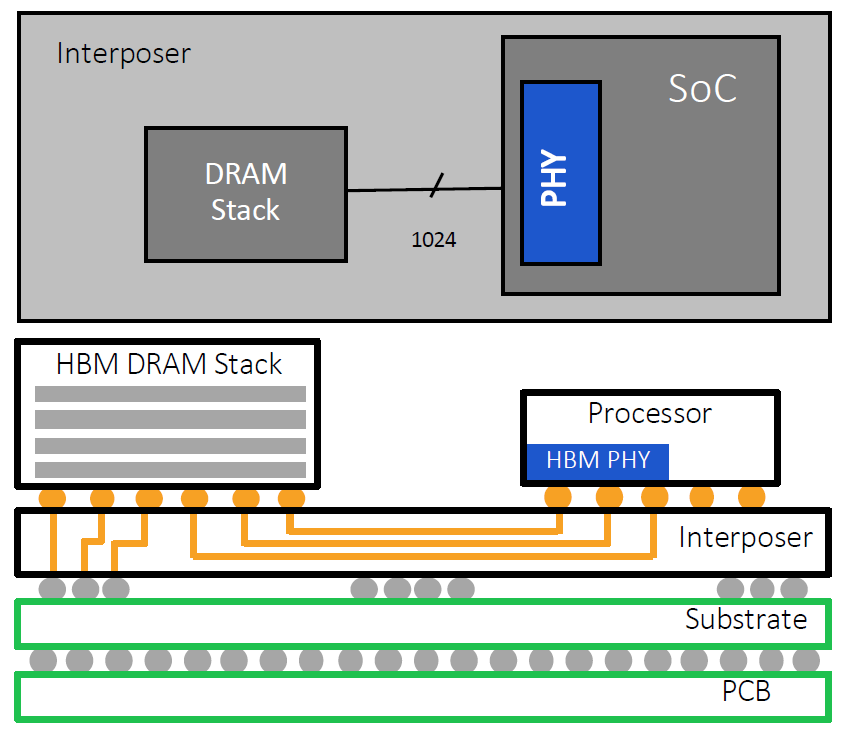

HBM2E 内存系统单个2Gbps HBM2E设备

所有版本的HBM都以相对较低的数据传输速率运行,但通过采用极宽的接口实现了非常高的带宽。具体地说,每一个运行速度高达3.6Gbps的HBM2E堆栈通过1024个数据“线”的接口连接到它的相关处理器。通过命令和地址,线的数量增加到大约1700条。这远远超出了标准PCB所能支持的范围。因此,硅中介层被采用作为连接内存堆栈和处理器的中介。与SoC一样,精细数据走线可以在硅中介层中以蚀刻间隔的方式实现,以获得HBM接口所需数量的数据线数。

单一DRAM堆栈的HBM2E内存系统

HBM2E 和GDDR6: AI内存解决方案

HBM2E提供了达成巨大内存带宽的能力。连接到一个处理器的四块HBM2E内存堆栈将提供超过1.8 TB/s的带宽。通过3D堆叠内存,可以以极小的空间实现高带宽和高容量需求。进一步,通过保持相对较低的数据传输速率,并使内存靠近处理器,总体系统功率得以维持在较低水位。

采用HBM的设计的代价是增加复杂性和成本。中介层是一个附加元件,必须进行设计、特性化和制造。与制造传统DDR型内存(包括GDDR)的巨大容量和制造经验相比,3D堆叠内存的出货量显得微不足道。最终的结果是,采用和制造HBM2E成本高于GDDR6。

出色的带宽、容量,低功耗的延迟、极小的尺寸空间,使HBM2E内存成为AI训练硬件的最佳选择。

然而,对于人工智能训练应用,HBM2E的优点使其成为一个更好的选择。它的性能非常出色,所增加的采用和制造成本可以透过节省的电路板空间和电力相互的缓解 。在物理空间日益受限的数据中心环境中,HBM2E紧凑的体系结构提供了切实的好处。它的低功率意味着它的热负荷较低,在这种环境中,冷却成本通常是几个最大的运营成本之一。

总而言之,HBM2E为系统设计者提供了极高的带宽能力和最佳的功率效率。虽说采用HBM2e系统的因设计复杂性和空间的增加,而更具挑战,但是板材面积的系统冷却支出的节省却是无与伦比。对于人工智能训练,HBM2E是一个理想的解决方案。这一事实是基于采用HBM2E强大成功记录之上的,例如已被采用人工智能的处理器,如英伟达的Telsla A100和谷歌第二代TPU。

第二部分:GDDR6 内存

图形DDR SDRAM(GDDR SDRAM)最初是20多年前为游戏和显卡市场设计的。在这段时间内,GDDR经历了几次重大变革,最新一代GDDR6的数据传输速率为16Gbps。GDDR6提供了令人印象深刻的带宽、容量、延迟和功率。它将工作电压从1.5V降低到1.35V以获得更高的功率效率,并使GDDR5内存的数据传输速率(16比8 Gbps)和容量(16比8 GB)翻了一番。Rambus已经演示了一个运行速度为18 Gbps的GDDR6接口,显示这种内存架构还有额外的增长空间。

与HBM2E不同,GDDR6 DRAM采用与生产标准DDR式DRAM的大批量制造和组装一样的技术。更具体地说,GDDR6采用传统的方法,通过标准PCB将封装和测试的DRAMs与SoC连接在一起。利用现有的基础架构和流程为系统设计者提供了 熟悉度,从而降低了成本和实现的复杂性。

带有四个 DRAM的 GDDR6内存系统

GDDR6内存出色的性价比,建立在经过时间考验的制造流程之上,使其成为人工智能推理应用的绝佳选择。

发表评论愿您的每句评论,都能给大家的生活添色彩,带来共鸣,带来思索,带来快乐。